在文章《数据中心存储的演变及未来展望》中,我们回顾了存储的历史,讨论了存储接口和协议的发展历程。文章最后提到,行业在 PCIe 接口的基础上推出了 NVMe 协议,来应对 SAS 和 SATA 等传统存储技术面临的天然瓶颈。那么,有了 NVMe就会让所有问题都会迎刃而解,是这样吗?

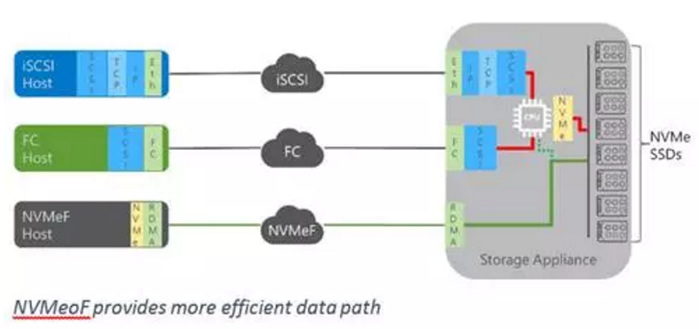

现实情况是:NVMe确实在延迟和吞吐量方面展现了难以置信的性能,但同时也面临一个棘手的问题:由于目前 PCIe 总线被作为物理接口,这些 NVMe 设备只能采用服务器-本地的方式进行部署。然而,服务器-本地存储其实又回到了 20 世纪 80年代的存储实施标准,这样一来,我们又会面临服务器-本地存储的全部固有问题,即复杂的管理和孤立的容量(而现在 NVMe 带来了孤立性能的问题)。20 世纪 90 年代,SAN 的出现帮我们解决了这一系列问题,通过使用光纤通道和以太网等远程数据网络,从服务器-本地存储转变为采用集中式解决方案来管理和共享存储。此外,我们还调整了传统的 SCSI 协议以便通过这些网络进行传输。

如果对 NVMe 采取类似的措施,会如何呢?

这并不是说我们应该继续使用过去 20 年来一直使用的低带宽网络,而是说我们不妨引入一些能够提供具有真正高带宽、低延迟的新选项。目前业界正在努力研发这些新选项,让 NVMe 在数据中心内得以发挥潜能。

理想情况下,我们希望轻松在数据中心内将 NVMe 的优势扩展到多个服务器和多个应用,也就是积极、动态地扩展 NVMe 以满足需求。这让我们在享受高性能 NVMe 优势的同时,还能获得通常需要使用 SAN 实现的集中式共享存储的最佳特性,而且不必再做出我们一直以来不得不接受的性能上的妥协。

为此,NVM Express 工作组在 2016 年推出了NVMe over Fabrics (NVMeoF) 规范。全新的 NVMeoF 规范使通用架构能够在 InfiniBand、RDMA over ConvergedEthernet (RoCE) 和 iWarp 网络基础设施(在保留现有常规以太网体验的同时,可提供每条链路每秒高达 100Gb 的吞吐量)等高级存储网络中传输 NVMe 协议。

例如,在 RoCE 结构上共享 NVMe 能从管理和应用角度提供多种优势,包括存储效率、简化管理、可扩展性……以及凭借极低的延迟(NVMeoF 的目标是增加的延迟 < 10?s)和 IOPS 实现的高性能。

在内部调查中,我们看到NVMe 为应用和工作负载带来了极大的好处,并且 NVMeoF 可以将这些优势扩展到本地应用服务器并进入数据中心。NVMeoF 是一项真正的变革性技术,它将影响今天和未来的数据中心战略。随着应用的发展和用户期望的提升,为它们提供支持的数据中心也必须发展。我们要根据具体应用及其角色,因地制宜地进行设计、部署和运营。例如NoSQL 和实时分析引擎等新兴系统更注重速度、敏捷性和适应性。这与电子邮件、数据仓库等传统系统截然不同,后者往往更注重稳定性、可靠性和可用性,并且看重如今 SAN 通常采用的广泛的集中式服务。

打造同时支持新兴和传统解决方案的数据中心并非易事,Gartner将此类数据中心称之为“双模式数据中心”。大部分数据中心的设计还并不支持新兴应用,但现在 NVMeoF 成为了建设“双模式”数据中心的关键推动因素,它提供出色的灵活性,既支持服务器-本地存储部署模式,也支持高级数据服务所需的以存储为中心的传统 SAN 式部署。采用的还是相同的技术,而且无需在每个解决方案的要求上做出重大妥协。

我对这项新技术的推出感到无比兴奋。在我看来,美光科技提供了表现最出色的 NVMe 技术,并且致力于让更多解决方案以更高效的方式享有NVMe 固态硬盘的性能,以满足更多应用类别的需求。美光科技致力于与业界合作,扩展这项伟大的新技术,让所有任务关键型应用获得更高水平的性能和灵活性。

本文作者:为美光高级技术市场工程师 Tony Ansley

存储在线

存储在线