在集群模式下运行的 NetApp Data ONTAP 8 软件是业内唯一一个能够从同一集群支持 NAS 和 SAN 协议的横向扩展统一存储平台。本期 Tech OnTap 中的另一篇文章提供了一个快速发展的云提供商部署集群模式的案例研究。此前也有 Tech OnTap 文章介绍过集群模式的特性和功能,以及经过 SPECsfs NFS 基准测试验证的性能和可扩展性。一个由 24 个 FAS6240 系统构成的集群每秒可执行超过 150 万次低延迟 SPECsfs2008_nfs.v3 操作。

鉴于集群模式具有如此令人惊叹的文件服务性能,人们自然会好奇它处理面向块的工作负载的性能。NetApp 进行了一项六节点 FAS6240 集群的 SPC-1 基准测试,并于近期提交了测试的结果。测试表明,上述集群的 SPC-1 IOPS 超过 250K(用于构建集群的某些组件与 SPECsfs 测试中所用的组件相同)。高 IOPS 与低延迟的结合使得这一结果成为企业磁盘存储系统 SPC-1 测试最佳结果之一。

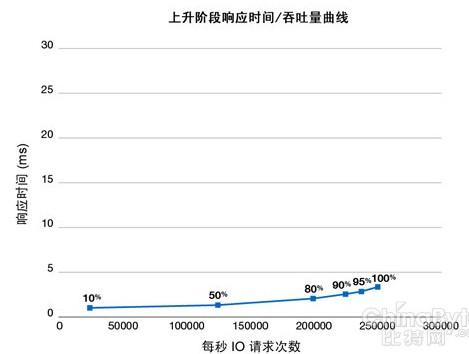

图 1) 六节点 NetApp FAS6240 集群的 SPC-1 IOPS。

在本文中,我首先介绍 SPC-1 基准测试,并将讨论延迟的重要性。然后更为详细地深入探究 NetApp 和其他供应商近期竞争的结果,再比较一下基于磁盘与基于闪存的存储。

SPC-1 基准测试

存储性能理事会 (SPC) 是存储供应商、集成商和学术机构联盟,旨在规定、标准化和促进存储基准测试。存储性能理事会的 SPC-1 基准测试是行业标准的、经过审核且基于块的严格基准测试,用于衡量磁盘子系统对工作负载(由包括写入、覆盖、读取后写入、写入后读取、热点以及随机和顺序操作在内的 I/O 混合而成)的处理性能。总体而言,因大约 60% 的工作负载是写入操作,而使得这种基准测试对于存储系统极具挑战性。I/O 大小不一,有大有小。

SPC-1 可能是模拟存储系统对数据库工作负载处理方式的最佳基准测试。SPC 开发该基准测试时,研究了各种应用访问存储的方式,然后根据这些衡量数据模拟了工作负载。混合操作代表一类广泛的应用,大约占所有商业应用的一半。

SPC-1 访问模式会引发热点,这在总工作负载中占据相当大的比例。如果进行测试的存储的自动存储分层 (AST) 系统达到足够的粒度和智能水平,则可能会将此类热点部分缓存(如果缓存足够大)或存储到 SSD 中。

尽管没有任何基准测试是完美无缺的,但要衡量随机块 I/O 性能和比较供应商之间的结果,SPC-1 或许是最佳标准化基准测试。如果某个存储系统在 SPC-1 基准测试中表现良好,则该系统在面对不断动态变化且难以处理的延迟敏感型工作负载(一般是数据库应用程序,尤其是 OLTP,还包括电子邮件和虚拟化)时,通常也能提供极高的性能。如果您有兴趣了解这项基准测试,则可阅读该测试的完整规范。

SPC-1 不是吞吐量类型的基准测试。要了解 Gb/秒测试的最佳结果,请查看其他资料。

解释基准测试结果

基准测试的秘诀在于对结果的解释。单单一个 IOPS 数字也许并不能完全说明问题。查看 SPC-1 报告时,您需要关注以下几点:

可持续性。所有 SPC-1 基准测试都要包含可持续性测试,并且该测试必须至少运行八个小时。理想的 IOPS 应始终保持较高的水平且具有持久性。间隔期间性能不能下降,持续性测试时间越长越好。

每个驱动器的 IOPS。该指标衡量存储系统驱动底层硬件的效率如何,每个驱动器的 IOPS 为 500 的效率是每个驱动器的 IOPS 为 250 的两倍。能够更高效地使用驱动器意味着达到指定性能水平所需的驱动器较少,这样可缩减成本与物理占用空间。

响应时间(延迟)。SPC-1 中的响应时间从应用角度来衡量完成平均 I/O 事务所需的时间长度。响应时间越短(响应速度越快)越好。IOPS 较高而响应时间较长的情况可能出现(但并不可取)。对于数据库事务,我们认为 10 毫秒的响应时间是处理读取操作时保持高性能的上限(如果超过 20 毫秒,Microsoft 等供应商会认为数据库"已中断"),而写入操作需要更快的响应,重做日志写入操作需要近乎即时的响应。

这些就是 NetApp 致力于实现低延迟结果的部分原因。有关 IOPS 和延迟的更多信息,请查看我最近的博文。

每次操作成本。该指标衡量每次操作必须花费多少美元。从根本上讲,计算方法是使用系统总价除以得出的 SPC-1 IOPS。但请注意,有些供应商报告的是折扣价,而另一些供应商报告的是标价,这样可能会使结果出现偏差。

RAID 保护。将哪种类型的 RAID 保护用于测试?大多数 SPC-1 结果使用镜像(RAID 10 或 RAID 1+O)来消除奇偶校验开销。这实际上意味着,与采用单奇偶校验或双奇偶校验 RAID 的相近可用容量比较,使用磁盘将支出更多成本。

需要的所有硬件。硬件配置的复杂程度如何?使用的是哪些类型的磁盘?这是您实际上可能会部署的系统,还是专门为了取得较好的基准测试结果而使用的系统?

NetApp SPC-1 结果

NetApp SPC-1 结果如上图 1 中所示。我们使用的是一个由 6 个 FAS6240 节点(3 个高可用性对)构成的集群,每个节点带有一个 512 GB 的闪存模块(FAS6240 标配),总共使用了 432 个磁盘驱动器(450 GB 的 15K SAS 驱动器,每个控制器 72 个驱动器)。

闪存是 NetApp 虚拟存储层 (VST) 的一部分,读取热数据将自动提升到闪存执行。一个 FAS6240 控制器最多可支持 3 TB 的闪存,因此,相比于典型数据中心配置的部署而言,将每个集群节点限制到一个 512 GB 的卡(系统标配)是规模更小的部署。

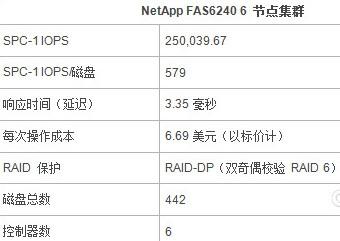

同样,由于一个 FAS6240 控制器最多可支持 1440 个驱动器,因此每个控制器仅使用 72 个驱动器也是很低的配置。使用的磁盘是 450 GB15K SAS 驱动器。需要注意的是,我们在所有测试中都启用了 RAID-DP® 技术 — NetApp 双奇偶校验 RAID 6 实现形式。这与标准的客户做法保持一致(RAID-DP 是 NetApp 默认项)。表 1 总结了相对于上述衡量指标的基准测试结果。

表 1) NetApp 通过 SPC-1 主要衡量指标体现出的性能。

此外,经过可持续性测试或可重复性测试,我们未发现性能随时间有所下降。在下一部分您会发现,NetApp 得到了令人非常满意的结果,尤其是能以较短的响应时间(延迟)提供较高的 IOPS。

与其他领先 SPC-1 结果的比较

我们根据大约 3 毫秒的响应时间阈值,对基于磁盘的领先 SPC-1 结果进行了分析。分析表明,在以低延迟提供指定 IOPS 的情况下,NetApp SPC-1 结果属于基于磁盘的企业系统的最佳结果。NetApp 通过主要基于 HDD 的配置,能够达到接近闪存水平的性能。

3 毫秒的响应时间目标符合要求苛刻的低延迟数据库应用程序(例如金融企业使用的应用程序)的需求。对于绝大多数数据库工作负载而言,非常低的 I/O 延迟可大大提高数据库的运行性能。

您可阅读我最近发表的关于这些结果的博文,查看更为详细的分析(外加评论)。

我们比较了以下几个存储系统(单击下面的超链接可转到每个存储系统的完整 SPC-1 基准测试报告):

• NetApp FAS6240 集群

• 带有 V7000 的 IBM SVC

• 带有 DS8700 的 IBM SVC

• Hitachi Data Systems VSP

• HP 3Par V800

• Huawei Symantec S8100

表 2) NetApp 集群与其他领先 SPC-1 结果的比较。

*这些数字的计算方法是,找到每个结果响应时间最接近 3 毫秒的数据点,然后报告该点的 IOPS。(表中显示了每个数据点的准确响应时间。)

SPC-1 IOPS 和每个磁盘的 IOPS 以及每次操作成本

表 2 从各个方面比较了六个系统的 SPC-1 结果。无可否认,有些系统达到的原始 SPC-1 IOPS(第一行)高于 NetApp FAS6240 集群。但是,NetApp 每个磁盘的 IOPS 达到其他供应商结果的两倍以上,而且能提供最低的每次操作成本(以标价计)。我已将表中的定价规范化,使其反映所有配置的标价(有些供应商在提交的 SPC 中报告的是折扣价,造成若不规范便无法加以比较的情况)。

低延迟 IOPS

比较一下所有系统在 3 毫秒延迟情况下的最高性能(在表中以粗体显示),您会发现只有一个系统(即带有 V7000 的 IBM SVC)的性能超过 NetApp 系统,但仅仅高出 4%。该系统的价格约为 NetApp 集群的 3.5 倍(以标价计),而且该系统带有 8 个 SVC 虚拟化引擎、16 个 V7000 系统(每个系统包含 2 个 SVC 控制器和 2 个 RAID 控制器)以及 1,920 个 15K RPM 146 GB 磁盘驱动器(或许不是您目前大量购买的驱动器。),其复杂性远远高于 NetApp 集群。较之由 6 个控制器(带有 432 个磁盘)构成的 NetApp 集群,该系统要配置、管理和支持更多的组件。

系统复杂性

总体而言,与表中所示其他存储系统相比,NetApp FAS6240 集群能以更少的硬件和少得多的磁盘获得良好的结果,并且是在测试中唯一一个采用双奇偶校验 RAID 而非镜像的存储阵列。这意味着更简单的管理、更低的管理和能源成本,以及更切合实际的总体配置。

闪存是否能提供合适的解决方案?

完全基于 DRAM 和闪存的系统能提供极高的 IOPS 和非常短的响应时间,尽管这些系统的 SPC-1 结果已存在,但是到目前为止,这些系统在实现高 IOPS 的同时,并不能提供企业通常需要的容量或功能。如果您对容量的要求不高,但需要极高的 IOPS,则当然有必要评估完全基于闪存或完全基于 DRAM 的解决方案,但是需要斟酌取舍。

NetApp 也提供完全基于闪存的方案,但是在未来一段时间内,一旦您的容量要求超过数十 TB,出于经济性的考虑,基于磁盘或磁盘加闪存的混合存储系统仍是更好的选择。表 3 列出了通过粗略计算得出的成本差异,显示了每 TB 原始容量的大体成本。

表 3) 容量成本:DRAM 和闪存阵列较之 NetApp 集群。

结论

凭借这一 SPC-1 结果,NetApp 证明了 Data ONTAP 8 集群模式能够以卓越的性能处理 SAN 和 NAS 工作负载。集群模式可实现:

• 低延迟(响应时间)与高性能

• 可动态扩展的 FC、iSCSI、NFS 和 CIFS 统一集群

• 极高的性价比

• 无中断运行,例如跨集群节点(包括 CIFS)的数据移动,而跨 CIFS 的数据移动通常几乎无法实现

• Data ONTAP 功能组合包括写入优化、应用感知、Snapshot™ 副本、重复数据删除、数据压缩、复制、精简配置、虚拟存储分层等

• 能够将用于 7-模式的硬件用于集群模式,包括 V 系列平台 — 可对其他供应商的存储阵列实施虚拟化

作者:系统工程师 Dimitris Krekoukias

Dimitris 从事 IT 行业已超过 17 年,在存储、大规模备份和恢复、虚拟化、大规模并行系统以及高性能计算领域拥有丰富的经验。自从三年前加入 NetApp 以来,他一直担任性能和竞争主题专家。他定期在 http://www.recoverymonkey.org/ 上发表有关性能和其他主题的博客。

存储在线

存储在线